« Toujours plus accessible » ! C’est ce qui me vient à l’esprit en premier en voyant la démo du futur outil du Creative Cloud dédié à l’animation de personnage.

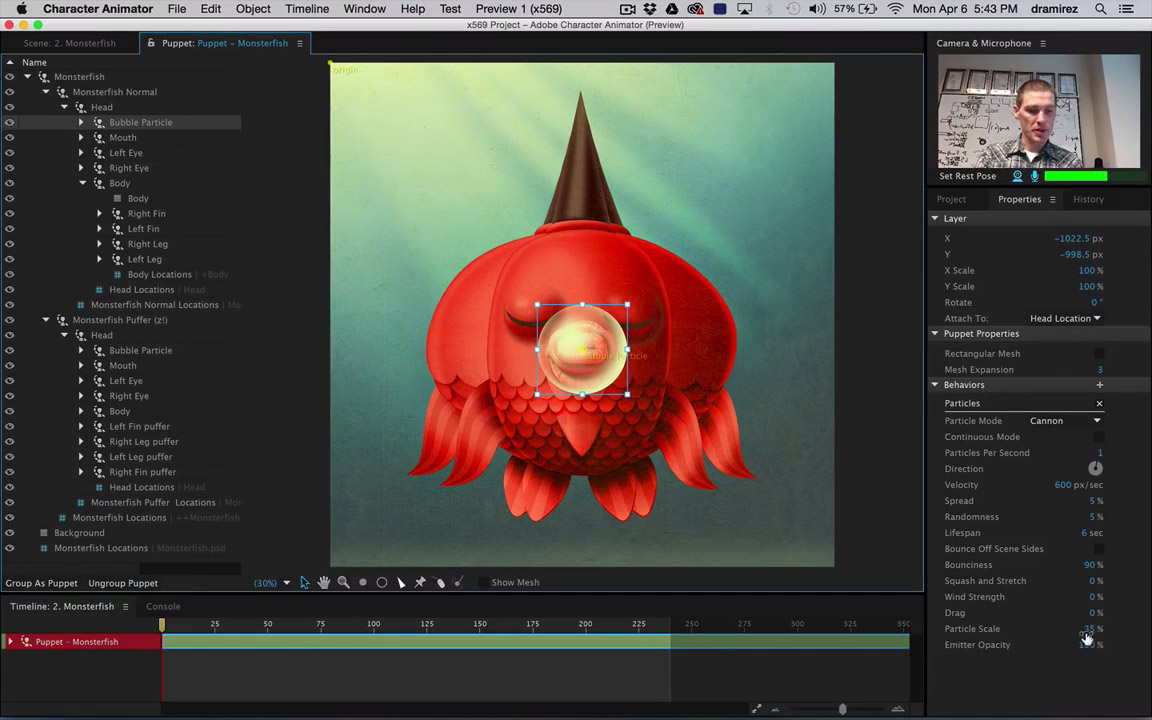

Sa puissance réside dans la fait que les personnages prennent vie directement par le biais de la webcam et du micro par une synchronisation du mouvement des lèvres sur la parole et une reproduction des expressions faciales, clignement des yeux, positionnement des sourcils, mouvements de tête en position, échelle et rotation.

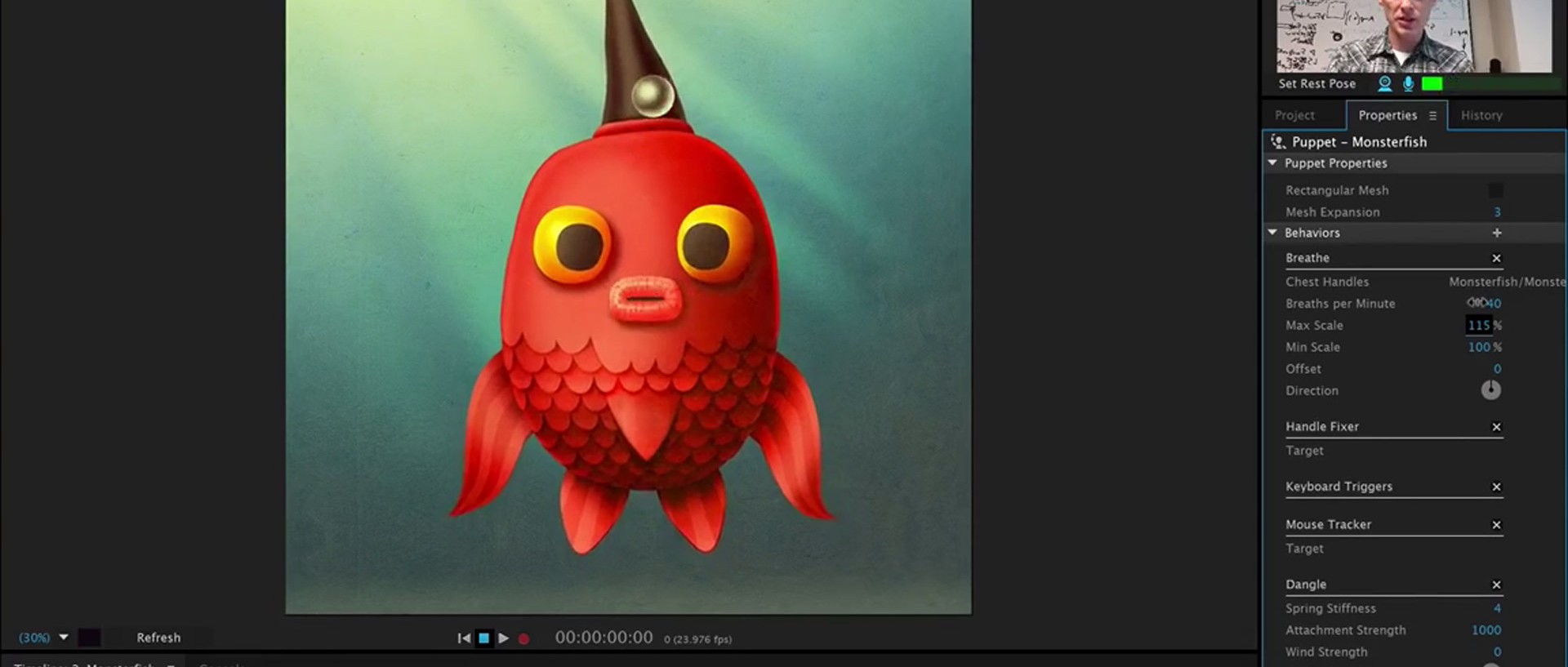

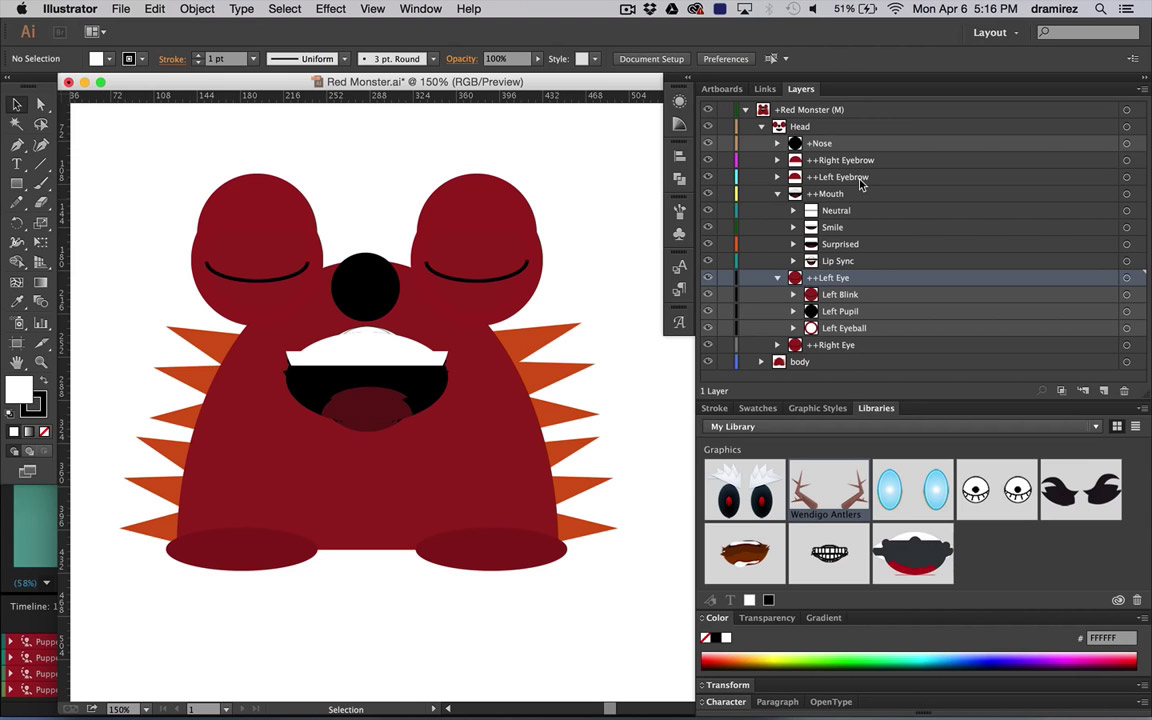

Adobe Character Animator s’utilise en important ses assets sous formes de calques directement depuis Photoshop ou Illustrator. On crée au préalable les différents comportements qui seront animés.

Désormais, l’animation s’exécute en temps réel, fini les heures de placement d’images clés, la souris et le clavier peuvent diriger les bras, les jambes, enregistrés en live.

Le tout pourra être enrichi par une bibliothèque de comportements qui pourront être rendus sous forme de scripts et presets (Adobe en fournira certains mais il sera possible de créer les nôtre et de les partager). Des éléments physiques comme la respiration seront aussi ajoutés.

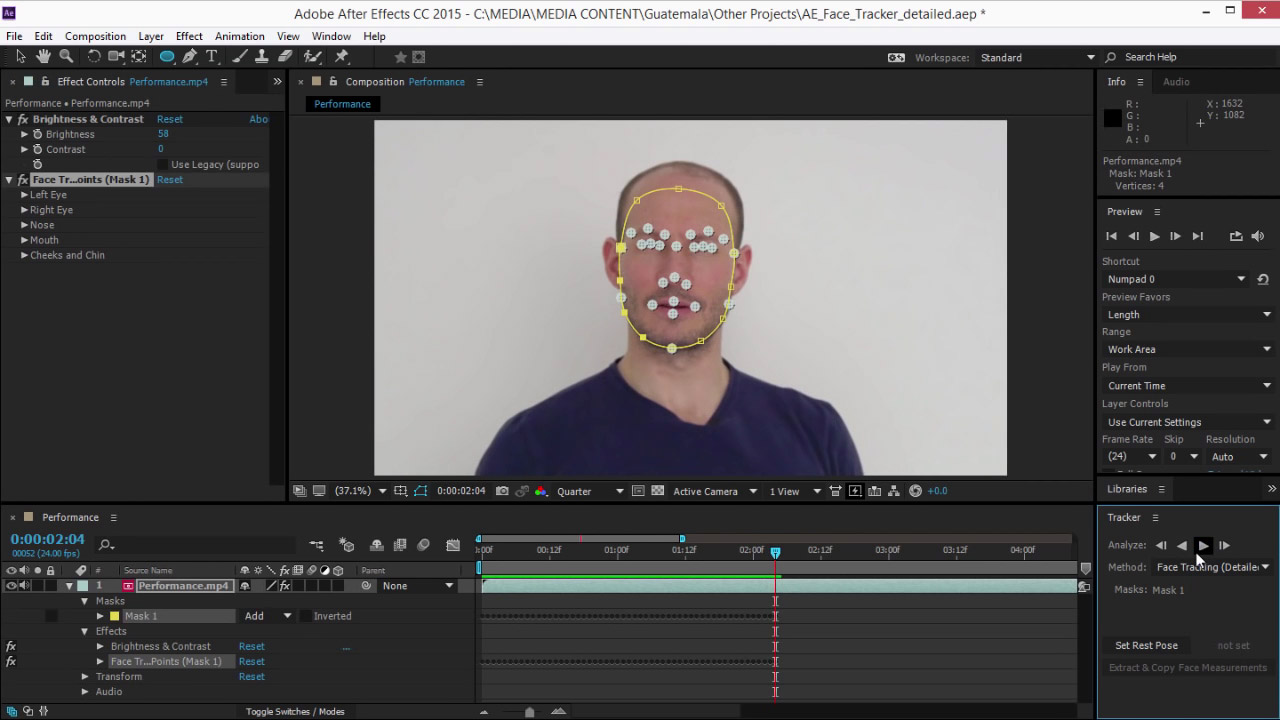

Pour l’instant, le logiciel n’existe qu’en preview, il sera installé en même temps que la future version d’After Effects CC et pourra fonctionner en parallèle avec le nouvel outil de tracking facial d’AE « Face Tracker ». On exportera les données de tracking facial issues d’un comédien sur une vidéo pour les récupérer sous Character Animator et reproduire directement sur notre personnage virtuel les expressions, ouverture des yeux et de la bouche et mouvement de tête de notre comédien.

J’avais commencé l’article par « toujours plus accessible », c’est vrai, les logiciels deviennent de plus en plus puissants et facilitent la production en gain de temps par le nombre de manipulations qui se réduisent pour des résultats plus réalistes. Reste ensuite la valeur ajoutée de nos métiers qui évolueront aussi…